Если вы активно пользуетесь ChatGPT, вероятно, вам знакомы случаи, когда этот чат-бот с искусственным интеллектом временно прекращает работу или выходит из строя в самый неудобный момент. Хотя такие сбои обычно не длительны, после недавнего инцидента, который поставил меня в затруднительное положение, я решил поискать более надежную альтернативу. К моему удивлению, я обнаружил простое решение в виде моделей локального бота, таких как LLaMA 3. И самое интересное — эти модели могут работать даже на обычном оборудовании, например, на MacBook Air! Вот что я узнал, используя LLaMA 3, и сравнивая его с ChatGPT.

Почему вам следует заботиться о локальных чат-ботах с искусственным интеллектом

Большинство из нас в свое время пользовались только ChatGPT и известными альтернативами, такими как Microsoft Copilot и Google Gemini. Однако все эти чат-боты работают на мощных серверах в удаленных центрах обработки данных. Но использование облачных сервисов подразумевает полное доверие к чужим компьютерам, которые могут выйти из строя или просто перестать работать на несколько часов.

Также неясно, как облачные чат-боты с искусственным интеллектом обращаются с вашими данными и обеспечивают конфиденциальность. Мы знаем, что ChatGPT сохраняет разговоры для обучения будущих моделей, и то же самое, вероятно, распространяется и на другие крупные технологические компании. Неудивительно, что компании по всему миру, от Samsung до Wells Fargo, вводят ограничения на использование ChatGPT внутри своих структур.

Чат-боты с искусственным интеллектом, доступные онлайн, не всегда обладают надежностью и сохранением конфиденциальности.

Именно здесь на помощь приходят локально управляемые чат-боты с искусственным интеллектом. Например, LLaMA 3, языковая модель с открытым исходным кодом, разработанная подразделением искусственного интеллекта Meta (признана в РФ экстремистской организацией и запрещена). Главное преимущество LLaMA с открытым исходным кодом заключается в том, что каждый может загрузить и запустить его самостоятельно. Поскольку данные никогда не покидают ваш компьютер, вы можете быть уверены в сохранении конфиденциальности.

Единственное требование для запуска LLaMA 3 — это относительно современный компьютер. К сожалению, это ограничивает использование на смартфонах и планшетах. Тем не менее, я обнаружил, что уменьшенную версию LLaMa 3 можно запускать на довольно доступном оборудовании, включая множество ноутбуков, выпущенных за последние несколько лет.

LLaMA 3 против ChatGPT: как работает офлайн-ИИ?

В следующем разделе я подробно опишу процесс установки LLaMA 3 на компьютере, но перед этим вы можете ознакомиться с тем, как он функционирует по сравнению с ChatGPT. Ответ на этот вопрос неоднозначен, так как ChatGPT и LLaMA 3 существуют в разных вариантах.

До прошлого месяца бесплатная версия ChatGPT ограничивалась более старой моделью GPT-3.5, и пользователи должны были оплачивать 20 долларов в месяц за использование GPT-4. Однако с появлением GPT-4o OpenAI теперь предоставляет бесплатный доступ к своей последней модели с некоторыми ограничениями на количество сообщений, которые можно отправить в час.

LLaMA 3 также предлагается в двух размерах моделей: 8 миллиардов и 70 миллиардов параметров. Версия 8B — единственный вариант для тех, кто имеет ограниченные вычислительные ресурсы, что, по сути, включает в себя всех, кроме самых усердных геймеров на ПК. Для более крупной модели 70B требуется как минимум 24 ГБ видеопамяти (VRAM), которая в настоящее время доступна только на экзотических графических процессорах стоимостью около 1600 долларов, таких как Nvidia RTX 4090. Даже при этом вам придется довольствоваться урезанной версией, поскольку для полной модели 70B потребуется 48 ГБ видеопамяти.

Учитывая все эти факторы, естественным выбором для нас стала LLaMA 3 8B. Хорошей новостью является то, что он отлично справляется с GPT-3.5 или базовой моделью ChatGPT. Вот несколько сравнений между ними:

Подсказка 1. Напишите сопроводительное письмо на должность инженера DevOps на Вконтакте. Я работаю в Яндексе с момента получения диплома инженера-программиста в 2019 году.

Результат : Практически ничья, хотя я больше предпочитаю точечный подход GPT.

Подсказка 2 : Сколько будет 8888×3+10?

Результат : оба чат-бота решили правильно.

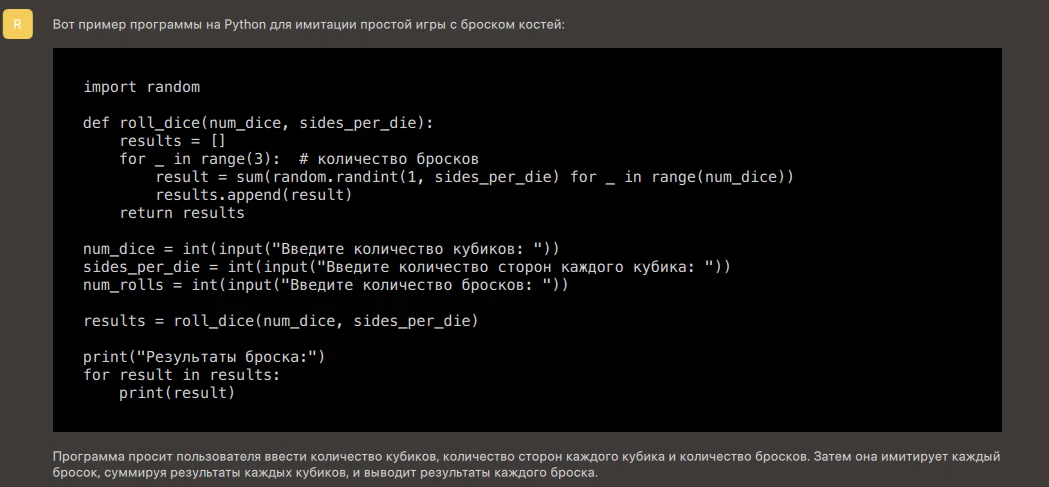

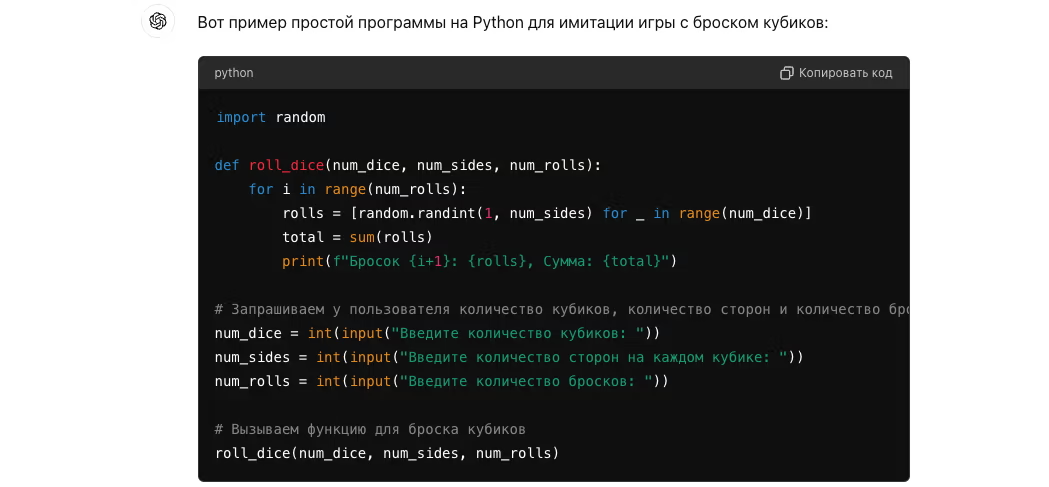

- Подсказка 3. Напишите короткую программу на Python, которая имитирует простую игру с броском костей. Программа должна позволять пользователю указывать количество кубиков, количество сторон каждого кубика и количество бросков. Затем программа должна вывести результаты каждого броска.

Результат : оба чат-бота создали рабочий код.

Следует отметить одно предостережение: ни GPT-3.5, ни LLaMA 3 не имеют доступа к Интернету для получения актуальной информации. Например, при запросе у обеих моделей данных о SoC Pixel 8 они дали уверенные, но абсолютно неверные ответы. Если вы зададите вопросы, касающиеся фактов, я буду относиться к ответам местной модели с большой долей скептицизма. Однако для творческих задач и даже для задач по программированию LLaMA 3 справляется очень хорошо.

Как загрузить и запустить LLaMA 3 локально

Как я уже упоминал ранее, LLaMA 3 выпускается в двух размерах. Модель LLaMA 3 8B не требует ничего, кроме современного компьютера. Запуск ее на моем рабочем столе дал более быстрые ответы, чем ChatGPT или любой другой онлайн-чат-бот, доступный сегодня. Хотя мой компьютер оснащен игровым графическим процессором среднего класса, LLaMA 3 также успешно работает на ноутбуке со скромным оборудованием. Например, я по-прежнему получал достаточно быстрые ответы, запуская ее на MacBook Air M1 с 16 ГБ оперативной памяти. Это оборудование уже четыре года, что старше, чем сам ChatGPT!

Для взаимодействия с LLaMA 3 вам понадобится программное обеспечение. Хотя модель можно скачать бесплатно, Meta не предоставляет ее в виде программы или приложения, которое можно просто запустить двойным щелчком. Однако, благодаря сообществу с открытым исходным кодом, сегодня у нас есть несколько различных интерфейсов для работы с LLM.

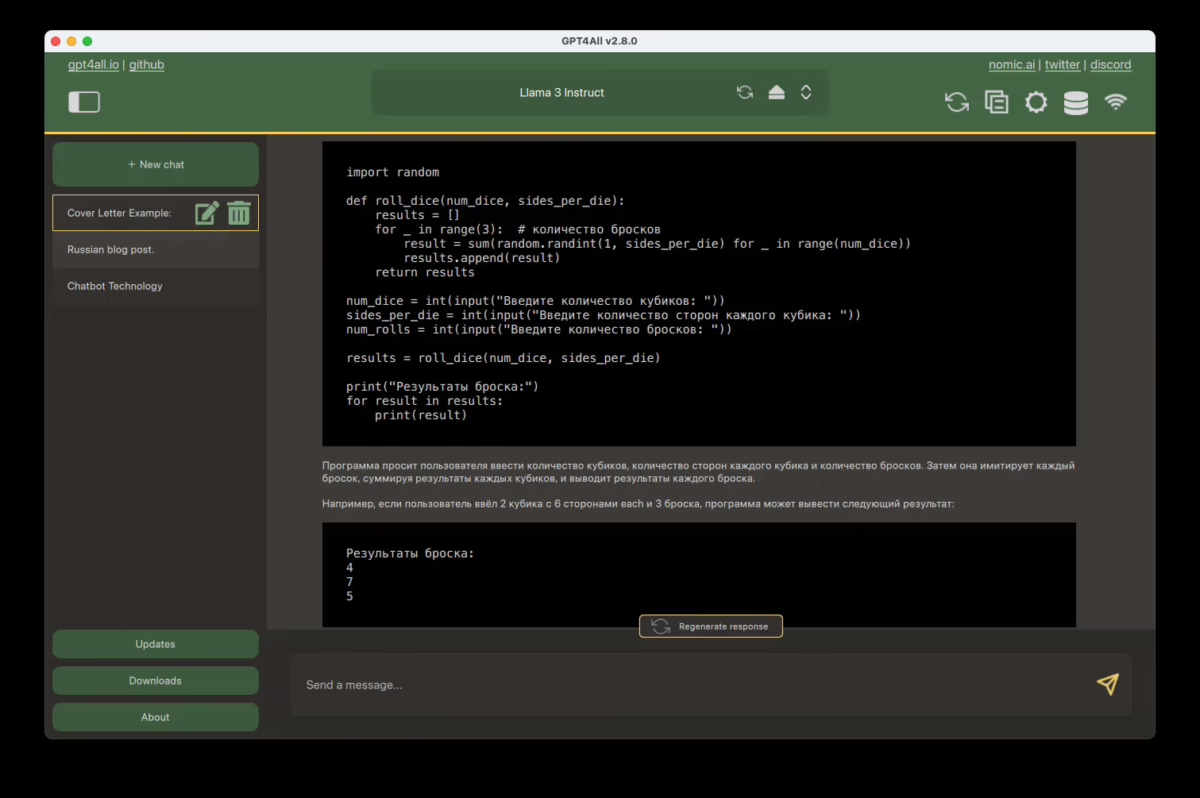

Попробовав несколько различных интерфейсов, я бы порекомендовал GPT4All, поскольку он делает процесс загрузки и запуска LLaMA 3 максимально простым. Вот краткое руководство:

- Загрузите GPT4All для вашего компьютера с Windows или macOS и установите его.

- Откройте приложение GPT4All и нажмите «Загрузить модели».

- Найдите модель «LLaMA 3 Instruct» и нажмите «Загрузить». Это модель 8B, идеально подходящая для разговоров. Загрузка может занять некоторое время в зависимости от вашего интернет-соединения.

- После завершения загрузки закройте всплывающее окно браузера и выберите LLaMA 3 Instruct в раскрывающемся меню модели.

- Всё готово — вы можете начинать общение. Просто введите подсказку, нажмите Enter и подождите, пока модель сгенерирует ответ.

Мой, безусловно, мощный рабочий стол может генерировать 50 токенов в секунду, что значительно превосходит скорость ответа ChatGPT. Компьютеры на базе Apple Silicon предлагают лучшее соотношение цены и производительности благодаря унифицированной памяти и генерируют токены быстрее, чем человек может их прочитать.

Если вы используете Windows без дискретной видеокарты, генерация текста в LLaMA 3 будет немного медленнее. На процессоре моего настольного компьютера генерация составляла всего 5 токенов в секунду и требовала как минимум 16 ГБ оперативной памяти. Однако облачные чат-боты также замедляются в периоды высокого спроса. Кроме того, я могу быть уверен, что мои чаты остаются полностью конфиденциальными.